tg-me.com/Conordevs_Blogs/330

Last Update:

Avvalgi postlarimdan birida ResNet haqida gaplashgandik: bu neyron tarmoqlarni chuqurroq qilishga yordam beradigan usul edi. Bugun esa AI tarixida Computer Vision (CV) yo'nalishida revolyutsiya qilgan model haqida gaplashamiz, ya'ni AlexNet haqida.

Hozir hamma AI modellar aksariyati neyron tarmoqlariga asoslangan arxitekturalar ustiga qurilgan. Ko'proq ma'lumot bersangiz, kuchliroq ishlaydi. Lekin, 1990-2010 yillar orasida neyron tarmoqlari boshqa Machine Learning (ML) algoritmlaridan yaxshiroq emas edi

2011-yilda Geoffrey Hinton (menimcha kimligini yaxshi bilsangiz kerak) o'z hamkasblariga shunday murojat bilan chiqdi: "Sizlarni neyron tarmoqlari kelajak ekaniga ishontirishim uchun nima qilishim kerak". Shunda uning tanishlaridan biri ImageNet deb nomlangan rasmlar to'plamini tavsiya qiladi.

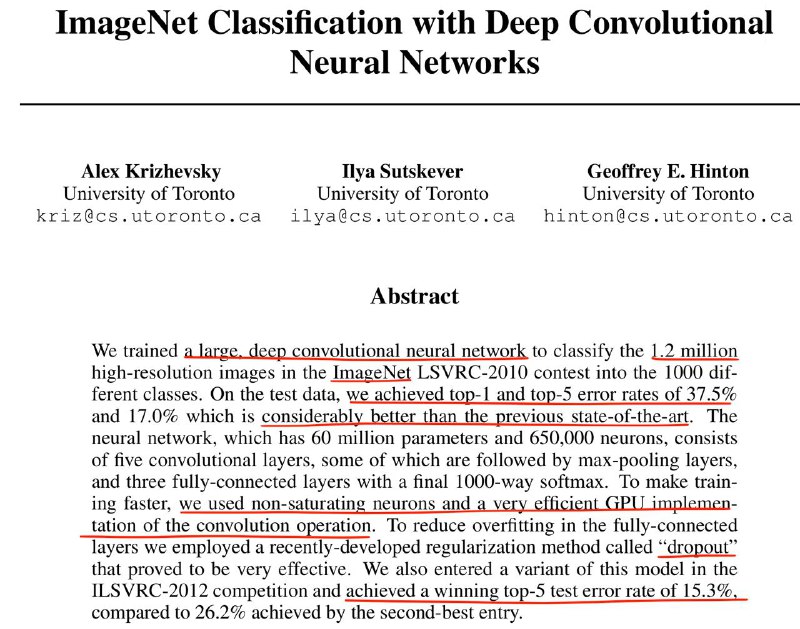

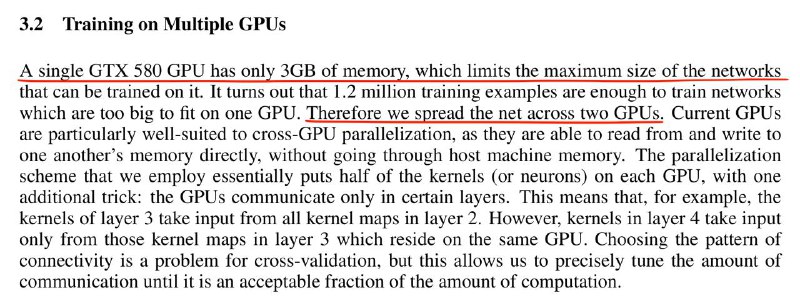

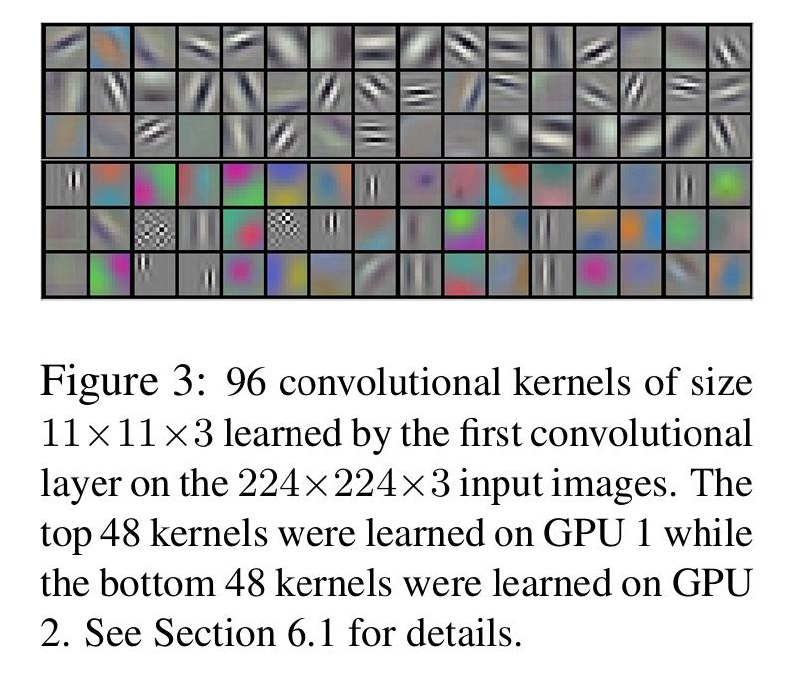

Ilya Sutskever (OpenAI asoschilaridan biri) va Alex Krijevskiy (AlexNet'ning muallifi) Geoffrey Hinton qo'l ostida PhD studentlar bo'lib o'qishar edi. Krijevskiy kichik modellarni CIFAR-10 dataset'ida o'qitish uchun cuda-convnet kutubhonasini yozgan edi. Sutskever Alex'ning GPU programming bo'yicha kuchliligini bilib, uni ImageNet yourdamida kattaroq model o'qitishga ishontiradi. Shunday qilib, Krijevskiy ko'p GPU mashg'ulotlari uchun `cuda-convnet`-ni kengaytiradi. AlexNet 2 ta Nvidia GTX 580 da o'zining ota-onasining uyidagi yotoqxonasida o'qitilgan.

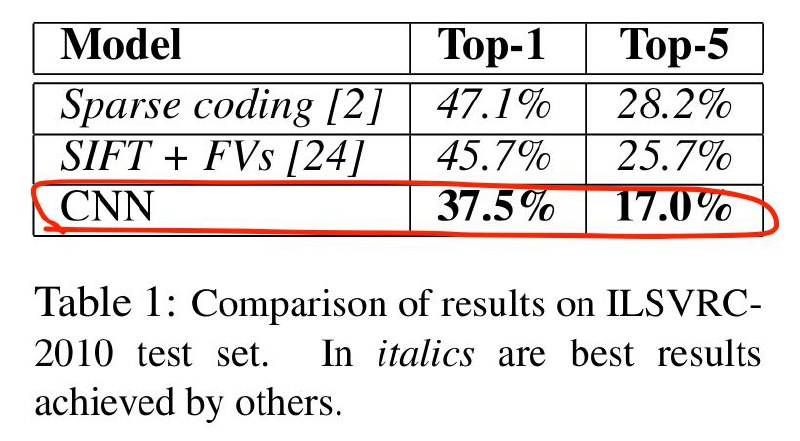

2012 yil davomida Krijevskiy tarmoqda giperparametrlarni optimallashtirishni amalga oshiradi, va u o'sha yilning oxirida ImageNet tanlovida g'olib chiqadi. Hinton shunday izoh beradi: "Ilya biz buni qilishimiz kerak deb o'yladi, Alex buni amalga oshirdi va men Nobel mukofotini oldim".

2012-yilda CV bo'yicha ECCV konferentsiyasida AlexNet g'alabasidan so'ng tadqiqotchi Yann LeKun modelni “bu CV tarixidagi aniq burilish nuqtasi” deb ta'riflaydi.

AlexNetning 2012-yildagi muvaffaqiyati oldingi o'n yil ichida yetuk bo'lgan uchta narsani birlashgani bilan amalga oshdi:

1. Katta miqyosdagi ma'lumotlar to'plamlari

2. Umumiy maqsadli GPU hisoblashlari (GPGPU), ya'ni Nvidia CUDA tehnologiyasi.

3. Chuqur neyron tarmoqlar uchun takomillashtirilgan o'qitish usullari.

O'n yildan ko'proq vaqt o'tgach, uning ahamiyati haqida fikr yuritar ekan, Fei-Fei Li 2024-yildagi intervyusida shunday deydi: "O'sha lahza sun'iy intellekt dunyosi uchun juda ramziy edi, chunki zamonaviy AI'ning uchta asosiy elementi birinchi marta birlashgan".

@kilich_bek_blog