tg-me.com/ai_machinelearning_big_data/7741

Last Update:

Epoch AI провели исследование, чтобы копнуть способность o3-mini в математическом ризонинге глубже, чем это происходит в популярных тестах и бенчмарках.

Они дали 14 математикам разобрать, как именно o3-mini-high решает сложные задачи из FrontierMath. Цель - понять ее сильные и слабые стороны в реальном математическом мышлении, а не просто фиксировать правильные ответы.

Так как внутренняя структура самой модели OpenAI не раскрывает, авторы сосредоточились на анализе ее рассуждений.

По 29-и "траекториям рассуждений" стало видно: модель не просто перебирает формулы, она действует как "индуктивный решатель на ощущениях" (по выражению одного математика).

Модель проявляет любопытство: пробует разные подходы, ставит "бюджетные эксперименты", чтобы прощупать задачу. Иногда даже пишет код для расчетов, избегая излишней абстракции.

Но стиль ее рассуждений часто неформальный, "черновой". Рассуждения излагаются приблизительно, без строгой формулировки, с пропусками сложных моментов – совсем не как это принято в математической среде.

Почему так? Возможно, строгие доказательства просто реже встречались в ее обучающих данных.

Главные проблемы модели – это обратная сторона ее же достоинств. Да, она эрудирована как никто (знает кучу теорем из разных областей – в 66% случаев она адресно применяла нужные знания, даже если подход был замаскирован).

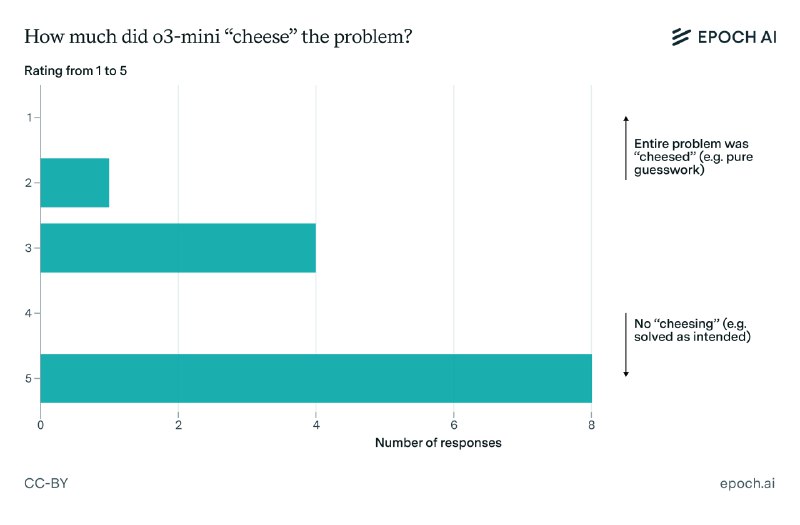

Но ей не хватает строгости и глубины. Она часто "читерит": делает верную догадку интуитивно и тут же применяет ее для решения, даже не пытаясь ее подтвердить доказательствами.

Порой ей не хватает буквально одного шага до верного ответа. Но главное – математики критикуют ее за слабую креативность. Как заметил один эксперт, модель похожа на аспиранта, который может блеснуть начитанностью, назвать кучу теорем и авторов, но не способен глубоко переосмыслить материал или придумать что-то новое.

Набор идей модели ограничен, и если они не срабатывают – прогресса нет. Плюс ко всему, в 75% рассуждений нашли галлюцинации: модель путает термины, формулы, и зачастую выдумывает несуществующие URL для поиска недостающей информации.

Модель, по заверением OpenAI, обучали на огромном массиве данных математической литературы. Это объясняет ее феноменальную эрудицию. Но смогут ли такие модели, как o3-mini-high, преодолеть свои слабости в будущем?

Или же системы, обученные на синтетических данных (AlphaProof), пойдут другим путем, предлагая в инфернесе рассуждения, мало похожие на человеческое математическое мышление?

А пока что вывод: o3-mini-high – это мощный, но своеобразный инструмент. Знаток с интуицией, но без дисциплины профессора.

@ai_machinelearning_big_data

#AI #ML #EpochAI