tg-me.com/nlp_stuff/298

Last Update:

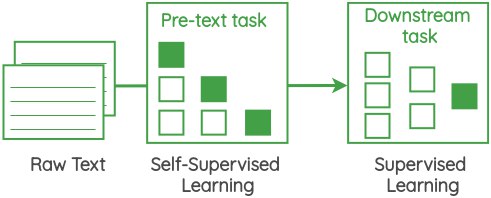

مرور روشهای SSL (Self-Supervised Learning) در پیشیادگیری NLP

آقا آمیت در این بلاگ پست (مال سال ۲۰۲۰عه) به صورت خیلی جمع و جور اومده یه مروری کرده که چه تسکهایی با SSL طراحی شدند که نقش pretext یا همون pretraining رو میتونند به عهده بگیرند. یکیش رو همین الان نقدا باید بدونید: Masked Language Modeling. این تسک شامل ماسک کردن کلمه و حدس زدنش توسط مدله که در برت استفاده شد. یازده تا روش این مدلی رو ایشون توضیح داده که مدل با اینا میتونه بدون اینکه لازم باشه دادهای لیبل بزنیم، از روی متن representationها رو یاد بگیره و بعد بتونه جلوی تسکهای مختلف قدعلم کنه. اگر ده دقیقه وقت دارید، این بلاگ پست رو بخونید و لذت ببرید.

این یازده تا روش به صورت یکجا به اضافهی مقالاتی که از این روشها استفاده کردند:

• Center Word Prediction (Continuous Bag of Words in Word2Vec)

• Neighbor Word Prediction (skip-gram in Word2Vec)

• Neighbor Sentence Prediction (Skip-Thought Vectors)

• Auto-regressive Language Modeling (Neural Probabilistic Language Model, GPT)

• Masked Language Modeling (BERT, RoBERTa and ALBERT)

• Next Sentence Prediction (BERT)

• Sentence Order Prediction (ALBERT)

• Sentence Permutation (BART)

• Document Rotation (BART)

• Emoji Prediction (DeepMoji)

• Gap Sentence Generation (PEGASUS)

لینک پست:

https://amitness.com/2020/05/self-supervised-learning-nlp/

#read

#blog

@nlp_stuff

BY NLP stuff

Share with your friend now:

tg-me.com/nlp_stuff/298