tg-me.com/ds_interview_lib/846

Last Update:

Вычисление важности признаков: когда она вводит в заблуждение

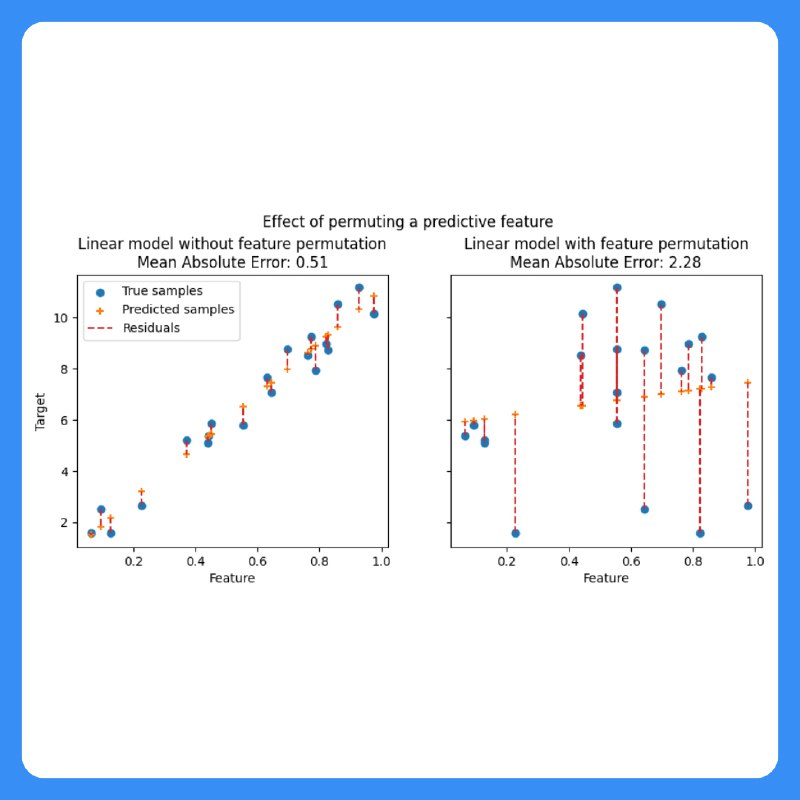

Вычисление важности признаков (Permutation Feature Importance) — популярный метод оценки вклада признаков в модель. Однако при наличии коррелированных признаков он может давать искаженные результаты.

🔸 Разделение важности: если два признака (A и B) сильно коррелируют, перестановка одного из них не снизит качество модели, так как второй содержит ту же информацию. Итог — заниженная важность.

🔸 Ложная высокая важность: малозначимый, но коррелированный с важным признак может получить высокий вклад просто из-за связи с важным признаком.

Что делать?

✅ Использовать SHAP, который корректно распределяет вклад.

✅ Применять PCA или регуляризацию (Lasso) для снижения корреляции.

✅ Проверять важность через drop-column importance.

BY Библиотека собеса по Data Science | вопросы с собеседований

Share with your friend now:

tg-me.com/ds_interview_lib/846