tg-me.com/kantor_ai/405

Last Update:

Вы просили про DeepSeek - ситуация вкрай запутана

Полный обзор всего загадочного и странного в этой истории по порядку:

Да, он хорош, но по бенчмаркам на уровне o1 от OpenAI без какого-то превосходства, да и по ощущениям (я пользую и ту и ту) на обычных жизненных задачах модели очень близки.

Но все равно успех DeepSeek удивителен, мы еще забываем про V3, которая ранее превзошла GPT4o и Claude 3.5

А еще DeepSeek лучше всех справилась с “последним экзаменом человечества" - тестом из 3 тыс. вопросов, большинство из которых составлялись учеными

Все модели

R1 получила 9,4%, а o1 всего 9,1% при том, что R1 не работает с картинками и такие вопросы пропускала

DeepSeek ворвалась в лидеры менее, чем за год, а еще ее модели открытые и бесплатные (говорят, халява на R1 до 8го февраля)

+ китайцы сделали хитрый ход, забрав полрынка разрабов — API DeepSeek’а на 100% совместимо с библиотеками OpenAI, т.е. для миграции нужно просто удалить платный API от OpenAI и вставить бесплатный от DeepSeek’а

Давайте разбираться..

Во-первых, есть мнение, что DeepSeek перенял наработки от Llama после ее мощного рывка в 2024м, когда она вынесла всех по бенчам и сделалась открытой..

Если это так, то тогда с какого момента считать стоимость обучения и что там в ядре на L0 (выложил в комменты уровни обучения моделей)?.. Если там Llama - тогда ясно, почему DeepSeek такая “дешевая”

Во-вторых, мы не знаем как и для чего учили модель..

Учитывая, что превосходство R1 не особо ощущается, может ее и учили на бенчи с арены - у всех “производителей” моделей эта практика стала нормой

А еще DeepSeek финансируется китайским хедж-фондом High-Flyer

В-третьих, сразу за взлетом R1 всплыл факт

Альтман почувствовал неладное - его беза узнала, что связанные с DeepSeek лица выкачивали через API OpenAI данные, обходя ограничения

..OpenAI и Microsoft инициировали расследование, но доказательств никаких нет

Т.е кто-то в OpenAI слил что нужно в DeepSeek, а DeepSeek с самого начала была “заточена” на низложение OpenAI.. Забавное свидетельство в конце поста))))

Да ничем - чем выше хайп в ИИ, тем меньше новости и колебания рынка связаны с реальностью

Рынок среагировал на x20 меньшую стоимость обучения R1, и типа все эти уже трлнные инвестиции в строительство мега-ИИ-кластеров не оправданы

Но обучение базовых моделей, думаю, забирает не больше 5% этих огромных мощностей.. Остальное тратится не на инфраструктуру для обучения таких моделей, а на инференс, т.е. вычислительные мощности для запуска тысяч ИИ-агентов для миллиардов людей, добавьте туда мультимодальность (обработка видео, голоса, изображений, логические размышления, растущий контескт и работа с памятью) - потребность во всем этом в эру агентности будет только расти

Поэтому, уверен, ребята из фонда, финансирующего DeepSeek, успели закупиться “дешевой” NVIDIA

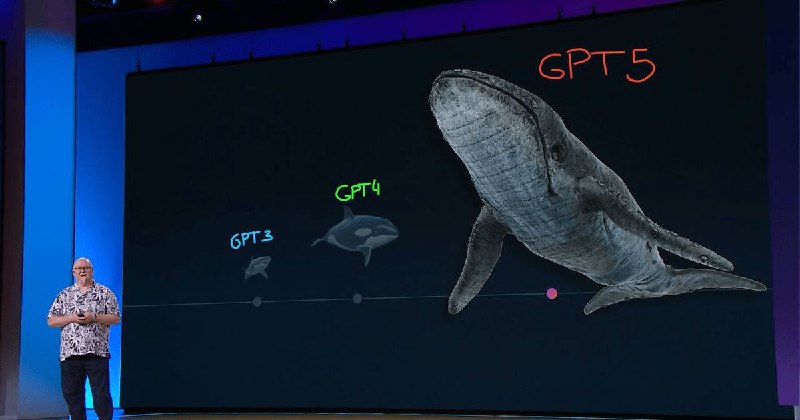

PS Ну и обещанная бомба)) Когда я писал пост, вспомнил слайд с презентации Microsoft в мае 2024, на котором показана эволюция GPT, где каждое поколение сравнивалось: GPT3 с акулой, GPT4 с касаткой, GPT5 с огромным китом.. (см. картинку☝️)

Все не просто так, и не ждите более в индустрии ИИ честной игры..

Все свидетельства изложенных фактов в комментах👉))

ЧИТАТЬ D_PEOPLE