tg-me.com/knowledge_accumulator/162

Last Update:

REINFORCE - главное оружие против недифференцируемых задач

Все мы в жизни сталкиваемся с ситуациями, когда есть какая-то функция полезности J, зависящая от параметров Theta. Если можно посчитать производную, то мы в шоколаде - пользуемся градиентным спуском. Но что, если нет?

Рассмотрим такую абстракцию - параметры системы Theta влияют на распределение действий A, а результатом этих действий является J. Если распределение на A не полностью сконцентрировано в одной точке, то существует способ получить несмещённую оценку на градиент J по Theta!

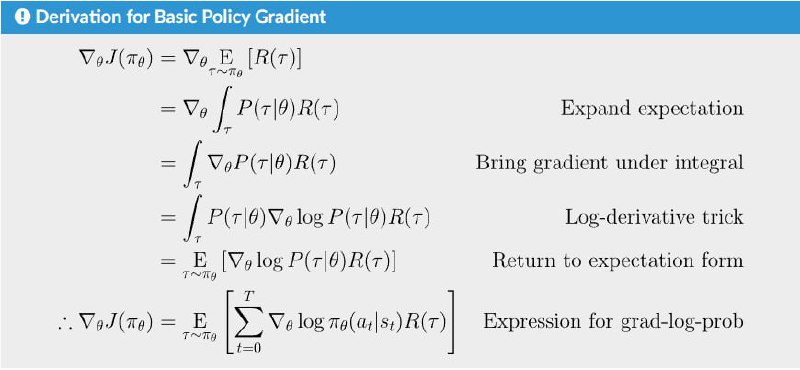

Тут-то и появляется REINFORCE / Policy Gradient. На картинке вывод формулы, сразу же применённый к ситуации, когда действий несколько и они составляют траекторию - tau. Буквой pi обозначается распределение действий A - его и называют стратегией (policy).

Итак, метод в теории рабочий, но дальше он сталкивается с жестокой реальностью - дисперсия оценки градиента безумна, требуется слишком много данных. Во многом RL сводится к тому, чтобы найти способ уменьшить дисперсию оценки. Тот же самый PPO, обычно используемый для RLHF - всего лишь костыль, позволяющий переиспользовать данные, шагая весами Theta несколько раз.

Ситуация с REINFORCE напоминает одну щекотливую тему. Казалось бы - у нас есть окончательное решение недифференцируемого вопроса - просто собирай данные и шагай по этому градиенту. Строго доказано, что достаточно отмасштабировать алгоритм, дать ему больше ресурсов, и он обучит всё, что угодно.

Но реальность печальнее. Можно сколько угодно рассказывать, что масштабирование решит все фундаментальные проблемы, но в конце концов придётся улучшать и сам алгоритм. Готовым кинуть в меня Bitter Lesson-ом предлагаю почитать мой пост про него, там есть о том, как этот урок многие понимают неправильно. Через десятки лет все будут смеяться над тем, что люди хотели с помощью предсказания следующего токена и RL поверх человеческой разметки обучить интеллект, как сейчас над тем, что люди пытались вручную придумывать фичи для компьютерного зрения.

@knowledge_accumulator

BY Knowledge Accumulator

Share with your friend now:

tg-me.com/knowledge_accumulator/162