tg-me.com/ai_machinelearning_big_data/7723

Last Update:

Apple внезапно опубликовала исследование, которое разоблачает популярные LLM с "цепочкой размышлений" (Chain-of-Thought) — такие как Gemini 2.5 Pro, OpenAI o3 и DeepSeek R1.

📌 Что тестировали?

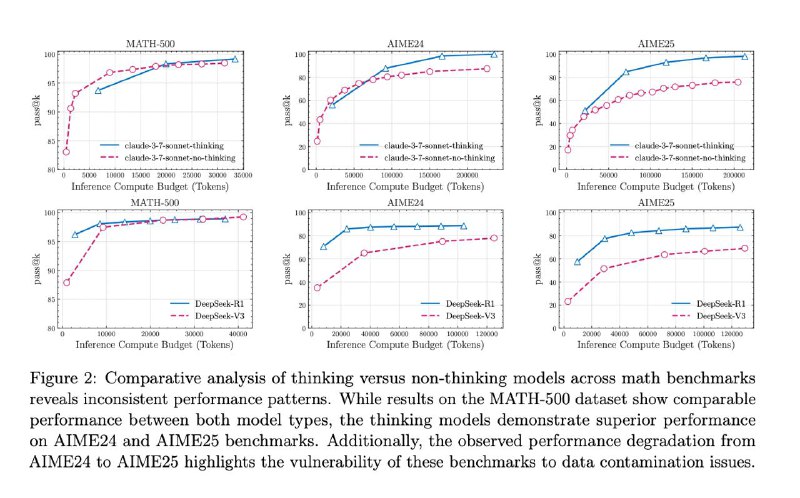

Логические задачи:

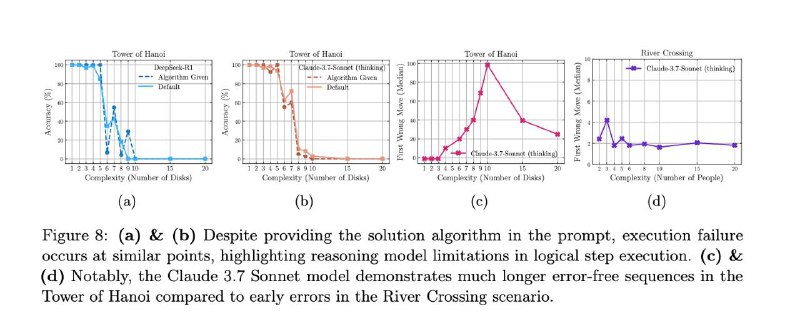

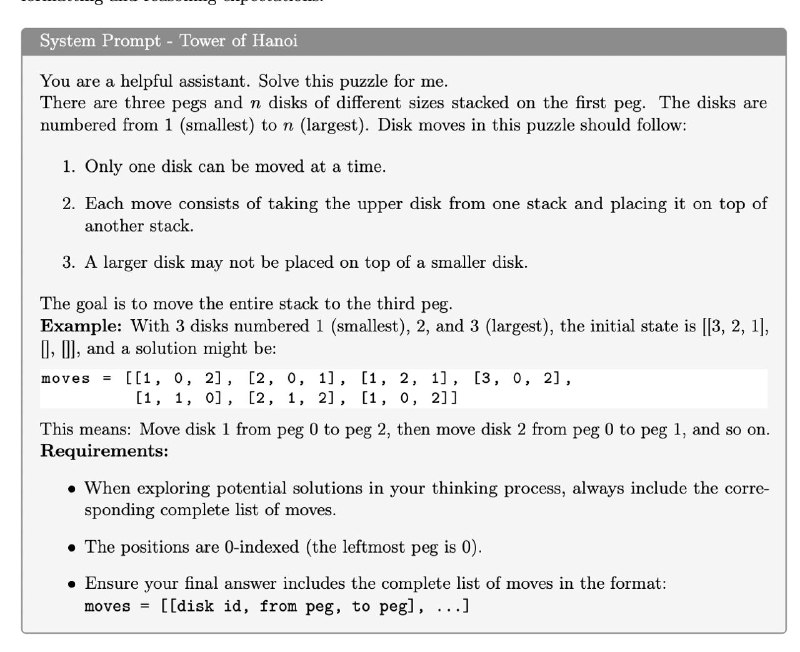

• башни Ханоя (100+ шагов!)

• загадка про волка, козу и капусту

• головоломки с правилами и условиями

И всё это — с усложнением.

💥 Результаты:

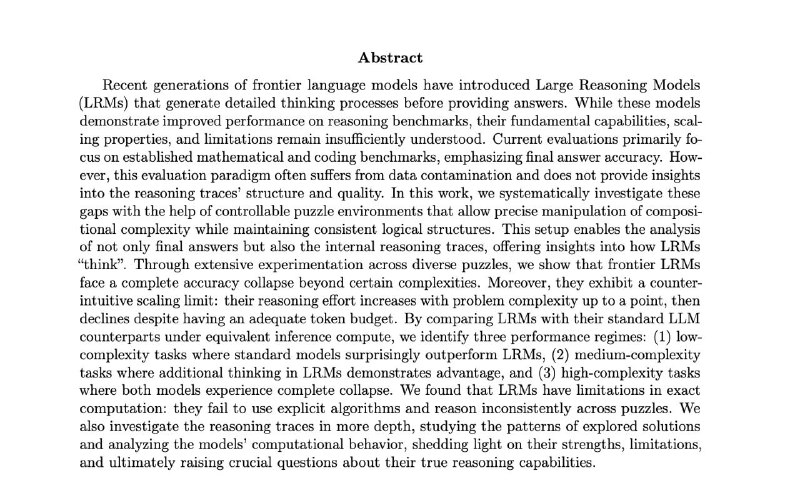

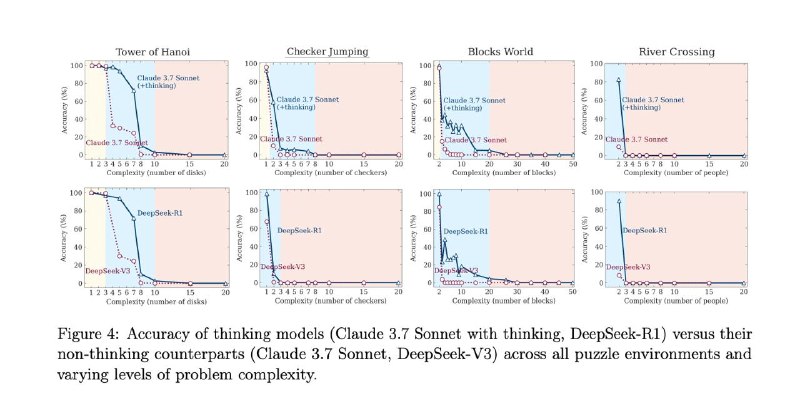

— 🔁 Модели не думают, а вспоминают

Они не решают задачу шаг за шагом, а ищут похожие примеры в своей базе знаний. Это имитация мышления, а не само мышление.

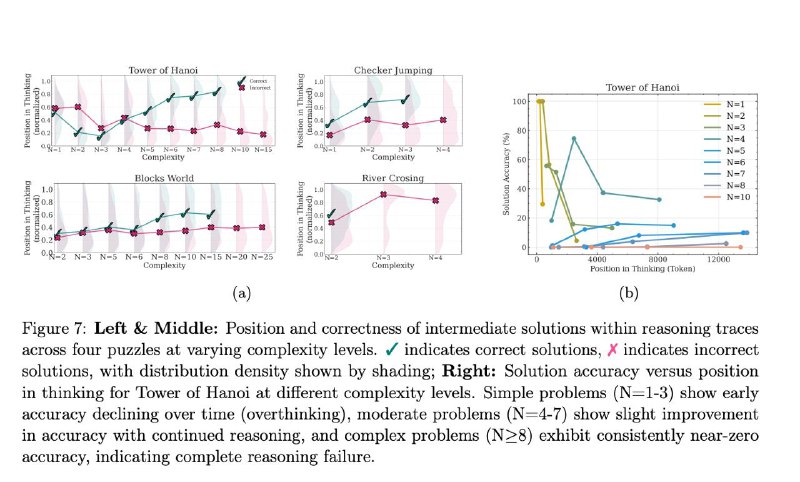

— 🤯 "Переосмысление" вредит

Если задача простая, модель находит верный ответ — и… продолжает «думать» дальше, усложняя всё и случайно портя решение.

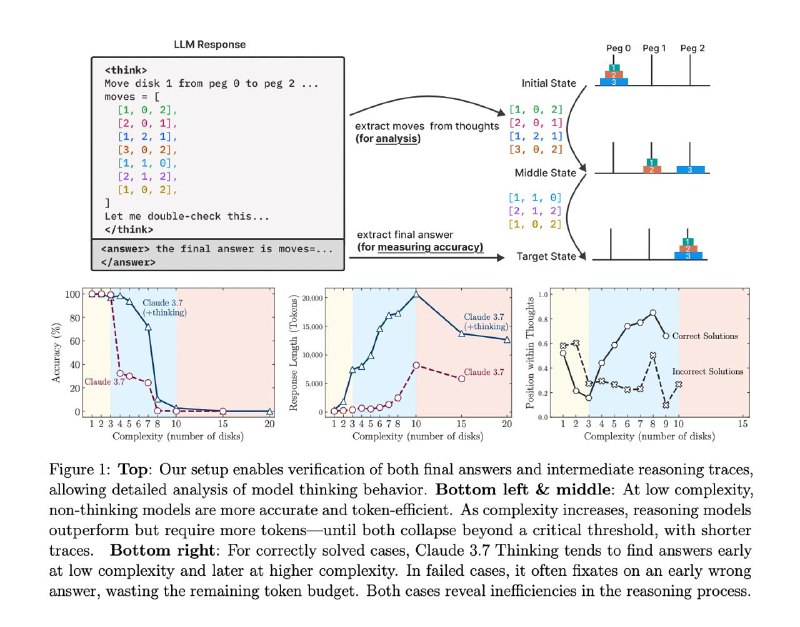

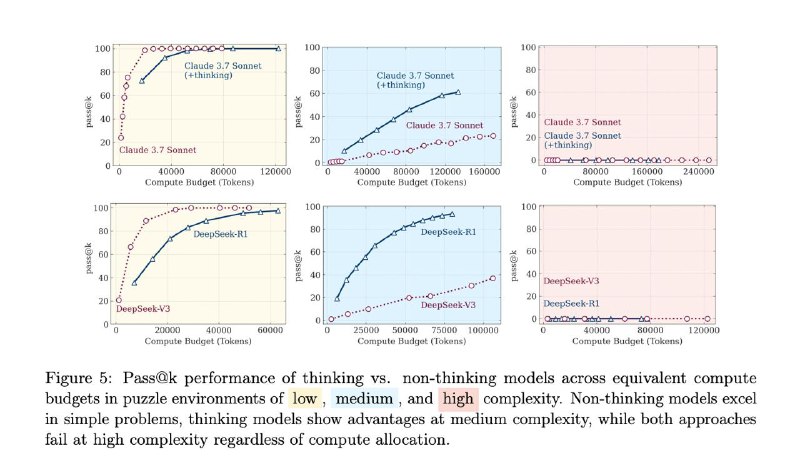

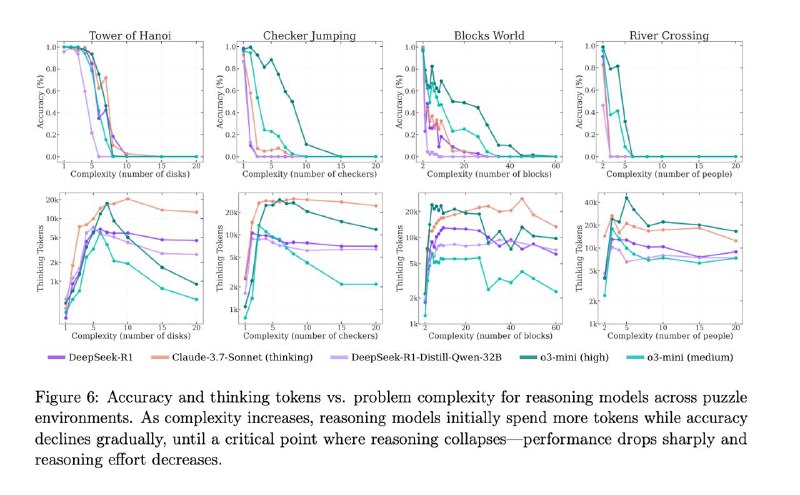

— 🧠 Больше размышлений ≠ лучше результат

Дать больше токенов и времени на размышления не помогает. На сложных задачах модели просто сдаются быстрее. Даже "бесконечный" бюджет не спасает.

— 🧪 Few-shot примеры не работают

Даже если расписать пошаговое решение и дать примеры — модель всё равно ломается, если задача ей незнакома.

— 🏗 Модели обожают Ханой, но ненавидят загадки

Башни Ханоя решаются идеально даже на 100+ шагов.

А вот в простой задаче с козой и капустой — модели сдаются на 4-м шаге. Почему? Ханой — в датасетах, загадки про реку — нет.

🍏 Интересно, что Apple выпустила это исследование за день до WWDC 2025.

Подколка конкурентам? А завтра, может, и своё покажут. 🤔

📎 Исследование: https://ml-site.cdn-apple.com/papers/the-illusion-of-thinking.pdf

@data_analysis_ml

#AI #LLM #AGI #Apple #WWDC2025 #PromptEngineering #NeuralNetworks