tg-me.com/ai_machinelearning_big_data/7414

Last Update:

Объемная и интересная статья Sebastian Raschka, автора книги "Build a Large Language Model From Scratch" о тенденциях и проблемах современных методов обучения LLM через призму RL.

В мире LLM последние месяцы стали переломными. Релизы GPT-4.5 и Llama 4, вопреки ожиданиям, не вызвали ажиотажа — все потому, что эти модели остались «классическими», без продвинутых методов обучения для рассуждений. Их конкуренты - xAI и Anthropic уже добавили кнопки «расширенного мышления», а OpenAI представила o3 — модель, где упор сделан на стратегическое применение вычислений через обучение с подкреплением. Становится ясно: масштабирование данных и параметров почти исчерпало себя, и будущее за RL.

Основной инструмент RLHF (обучение с подкреплением на основе человеческой обратной связи) давно используется для настройки LLM под предпочтения людей. Но для задач, требующих логики, этого недостаточно.

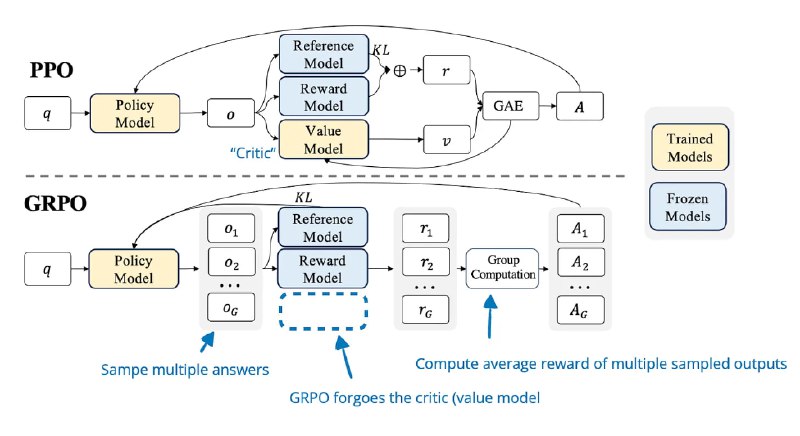

Здесь на сцену выходит GRPO — модификация алгоритма PPO, которая экономит ресурсы, убирая «критика» (модель оценки вознаграждения). Так создавалась DeepSeek-R1-Zero, ее обучали вообще без этапа SFT, используя только автоматические проверки ответов. Если математическая задача решена верно, модель получает «плюс», если нет — «минус». Такой подход не только дешевле, но и снижает риск «обмана» модели (reward hacking).

Но и RL — не панацея. Исследования показывают, что PPO и GRPO неявно поощряют длинные ответы, даже если те ошибочны. Например, при отрицательном вознаграждении штраф распределяется по токенам, и модель учится растягивать текст, чтобы смягчить наказание.

Решения уже есть: одни команды вводят штрафы за длину, другие меняют расчет преимуществ. А модель L1 от Kaggle и вовсе позволяет пользователям задавать желаемую длину ответа, балансируя между точностью и затратами.

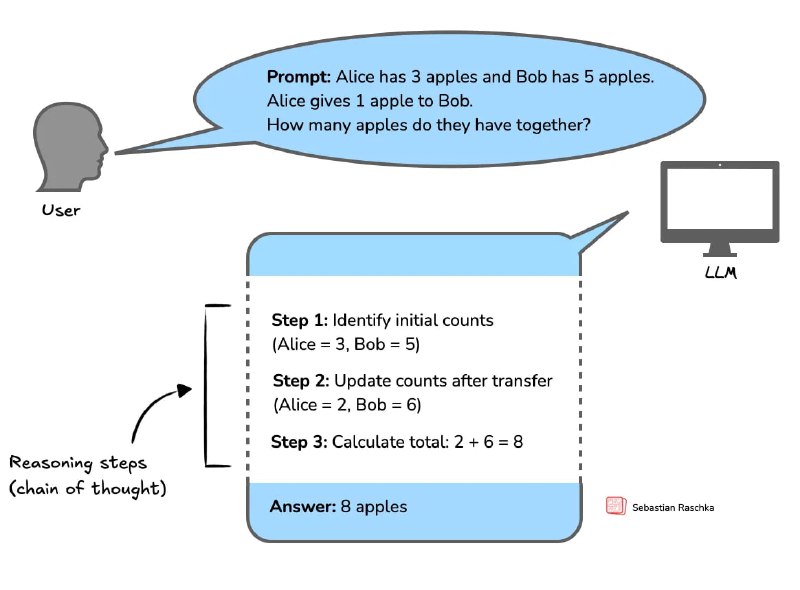

Способность к рассуждениям может возникать и без RL. DeepSeek V3 демонстрирует мыслительные «озарения», хотя ее не обучали специально. Этот факт всерьез ставит под вопрос исключительную роль RL — возможно, все дело в данных, где уже есть цепочки логических шагов.

Тем не менее, RL усиливает эти способности: модели начинают самокорректироваться, использовать внешние инструменты (калькуляторы, поиск) и даже переносить навыки между доменами — от математики до медицины.

Некоторые заявления о прогрессе оказались преувеличены: улучшения на мелких моделях часто нестабильны, а результаты зависят от случайных факторов вроде выбора сида. Кроме того, RL требует внушительных ресурсов (o3 от OpenAI потратила при обучении в 10 раз больше вычислений, чем предыдущая версия)

В итоге, RL остается ключевым направлением, но важно избегать «эйфории». Сочетание RL с автоматической проверкой ответов, контроль длины и гибридные подходы (как в DeepSeek-R1) — вот что приближает нас к моделям, которые не просто генерируют текст, а действительно думают.

@ai_machinelearning_big_data

#AI #ML #LLM #RL